Afsnit 9.5: Ridge regression

Definition 9.5.1.

(Ridge regression)

I ridge regression vælges en værdi af (regulariseringsparameteren),

og skøn over og i den multiple regressionsmodel

9.1.1 findes ved at minimere

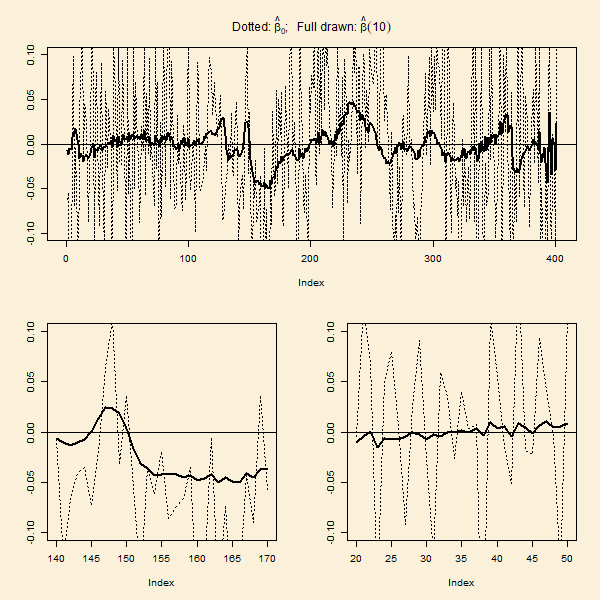

Når vi lader gå mod nul, får vi den stiplede løsning i

figuren ovenfor, og når vi lader blive meget stor,

får vi løsningen, hvor alle estimaterne af regressionskoefficienterne

er nul. I Definition 9.5.1 vægter alle regressionskoefficienterne

lige meget

i kvadratnormen. Dette forudsætter, at alle de forklarende variable

er på "samme skala". I implementeringen af ridge regression i det

følgende skjulte punkt foretages derfor en centrering og skalering

af alle de forklarende variable, og figurerne i dette afsnit,

såvel som angivne kvadratnormer, vedrører

regressionskoefficienterne hørende til de skalerede

variable.9.5.2 Ridge regression i python

For at finde løsningen og

til minimerigsproblemet 9.5.1 har jeg lavet en funktion ridge

(ligger i filen pytFunktioner.py, henholdsvis ridge.m).

Input til denne er matricen med de forklarende variable,

vektoren

med responsværdierne, og værdien af der ønskes undersøgt.

Output er , og

hvor

er den 'te forventede værdi. Normalt dividerer vi i et

spredningsskøn ikke med , men med et frihedsgradsantal.

For ridge regression er der imidlertid ikke et naturligt

frihedsgradsantal. I det følgende kodevindue er koden til

ridge skrevet ind, og

data omkring oktantallet i bensinprøver analyseres.

Der laves en figur af og en figur med

de observerede oktantal mod de forventede værdier.

Prøv at lege med koden ved at køre koden flere gange

med en følge af -værdier på formen

0.01,0.1, 1, 10, 100 og 1000. Hold især øje med, om der

kommer systematiske afvigelser fra identitetslinjen i

figuren med de observerede afsat mod de forventede.

Hvilken værdi af vil du vælge ud fra den

sidste synsvinkel ?

Når man har analyseret data, og besluttet hvilken værdi af

regulariseringsparameteren , der giver den bedste

tilpasning til data, vil man ofte bruge modellen til at

prædiktere respons (eller rettere middelværdien af respons)

for nye værdier af de forklarende variable.

Den prædikterede værdi er

hvor

er parameterskønnene fra ridge regressionen, og

er de nye forklarende værdier.

Med værdien som er værdien givet i koden, kan

man ikke se nogen systematisk afvigelse, og vi kan godt

prøve at gøre større. Med ser figuren

stadig acceptabel ud, men det yderste punkt i hver ende er

faktisk blevet rykket lidt bort fra identitetslinjen.

Med ser vi klare systematiske afvigelser,

hvor langt de fleste punkter med forventet værdi i den nedre halvdel

ligger under identitetslinjen. En værdi af omkring 10

synes derfor rimelig. I næste afsnit bliver cross-validation til

bestemmelse af omtalt.

9.5.3 Ridge prædiktion i python

De prædikterede værdier beregnes meget nemt i python.

Lad alpha og beta være output fra ridge-funktionen,

og lad Tnye være en matriks, hvor hver række

indeholder et sæt forklarende værdier, for hvilke man ønsker

at beregne en prædikteret værdi (i alt ønskes altså

prædikterede værdier). Beregningen foretages som følger,

Beregningsmetoden blev brugt i det ovenstående skjulte punkt

Ridge regression i python til at beregne de forventede værdier,

hvilket svarer til, at Tnye er den oprindelige matriks

med de forklarende værdier.Et approksimativt prædiktionsinterval for en kommende observation kan

laves som

hvor er prædiktionsspredningen

fundet ved cross-validation, hvilket beskrives i det næste afsnit.

ForegåendeNæste