Afsnit 9.6: Cross-validation i ridge regression

Resultat 9.6.1.

(Valg af regulariseringsparameter)

I ridge regression vælges værdien af regulariseringsparameteren

ved hjælp af cross-validation. Som udgangspunkt vælges den værdi af

der giver den mindste værdi af prædiktionsspredningen

Værdien kaldes Eventuelt vælges en værdi lidt større end der opfylder,

at ikke er meget større end

og et plot med de observerede mod

de forventede ikke viser systematisk afvigelse fra identitetslinjen.

For at finde prædiktionsspredningen ved LOOCV

har jeg lavet en funktion cvRidge.

Input til denne er matricen med de forklarende variable,

vektoren

med responsværdierne, og værdien af , der ønskes undersøgt.

Output er prædiktionsspredningen defineret som i

(9.3.2), og en standard error for baseret på

de værdier, der indgår i beregningen ().

I det følgende kodevindue er koden til

cvRidge skrevet ind, og

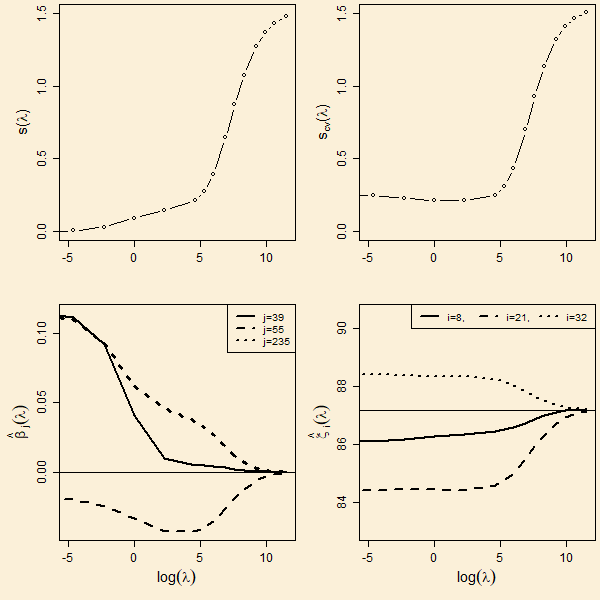

data omkring oktantallet i bensinprøver analyseres.

Prøv at køre koden flere gange

med en følge af -værdier på formen

0.1, 1, 10, 100 og 1000, og se at de fundne værdier

stemmer overens med figuren ovenfor.

I ovenstående eksempel har jeg lagt op til, at et endeligt

valg af er Minimum af

fås med valget

, og minimumsværdien er

Dette tal kommer med en usikkerhed (standard error),

og denne er vurderet til

i programmet cvRidge.

Der er delvist en tradition for, at man vælger en værdi af

lidt over den værdi, der giver minimum. Dette skyldes, at man ønsker

at regularisere løsningen mest muligt.

Nogle programmer har indbygget, at vælges som den værdi

større end hvor er

Jeg lægger ikke op

til at bruge denne regel automatisk. I stedet anbefaler jeg, at

man vurderer en værdi af lidt over

ved at se efter, om der optræder systematiske afvigelser i et plot

af de observerede mod de forventede. Ud fra en sådan tilgang vil jeg

vælge omkring 10 for bensindata.

Med er prædiktionsspredningen

som cirka er

Man skal vælge til cirka 60, for at få en prædiktionsspredning der

er For denne

værdi synes jeg, at der er tydelige systematiske afvigelser i et

plot af de observerede mod de forventede. Prøv selv i koden

Ridge regression i python

at køre og og se på de figurer

der dannes med de observerede afsat mod de forventede.

ForegåendeNæste